Een AI-handvat voor de IA

Met de komst van artificial intelligence (AI) krijgen we ook te maken met AI-risico’s. De vraag is hoe we hier als internal auditors mee om moeten gaan.

Het definiëren van AI heeft een complexe historie die teruggaat tot halverwege de 20e eeuw. Verschillende academische stromingen hanteren verschillende definities. Zowel academici als regelgevers onderkennen dat er geen algemeen geaccepteerde definitie bestaat. Een typerend discussiepunt is bijvoorbeeld het bepalen van de scheidslijn tussen kunstmatige intelligentie en eenvoudige automatisering. Autonomie, aanpassingsvermogen en impact op de omgeving spelen hierin een rol. Er is echter veel ruimte voor verschillende interpretaties.

De OESO (Organisatie voor Economische Samenwerking en Ontwikkeling) hanteert de volgende bruikbare definitie: ‘AI system means a machine-based system that is designed to operate with varying levels of autonomy and that may exhibit adaptiveness after deployment, and that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments.’

Generatieve AI

De opkomst van generatieve AI (waarbij een AI-model content genereert aan de hand van een vaak tekstuele geïnterpreteerde opdracht) veroorzaakte complicaties in de onderhandelingen over de Europese AI-verordening. Toen in april 2021 het eerste wetsvoorstel tot stand kwam, was generatieve AI nog niet breed onderkend. In een relatief laat stadium van de Europese AI-verordening is de term general purpose AI system (GPAIS) toegevoegd met specifieke vereisten over transparantie.

‘A general-purpose AI model means an AI model, including where such an AI model is trained with a large amount of data using self-supervision at scale, that displays significant generality and is capable of competently performing a wide range of distinct tasks regardless of the way the model is placed on the market and that can be integrated into a variety of downstream systems or applications, except AI models that are used for research, development or prototyping activities before they are placed on the market.’

Begrip van de technologie geeft een beter inzicht in de aard en de complexiteit van het AI-systeem

Voor de internal auditor is het relevant dat hij zich bewust is van de complexe aard van de AI-definitie. Verder is het nuttig om enige kennis te hebben van de techniek. Wordt binnen de organisatie gebruikgemaakt van machine learning om een model te ontwikkelen? Wordt het AI-model getraind met gestructureerde of ongestructureerde data? Verloopt de training volledig geautomatiseerd of is er tussenkomst van mensen voor nodig? Is het model intern of extern ontwikkeld? Begrip van de technologie geeft een beter inzicht in de aard en de complexiteit van het AI-systeem. Wanneer beperkt inzichtelijk is welke input en verwerkingen er plaatsvinden, wordt vaak gesproken van een zogenaamde black box AI-toepassing.

Wat zijn de risico’s van AI?

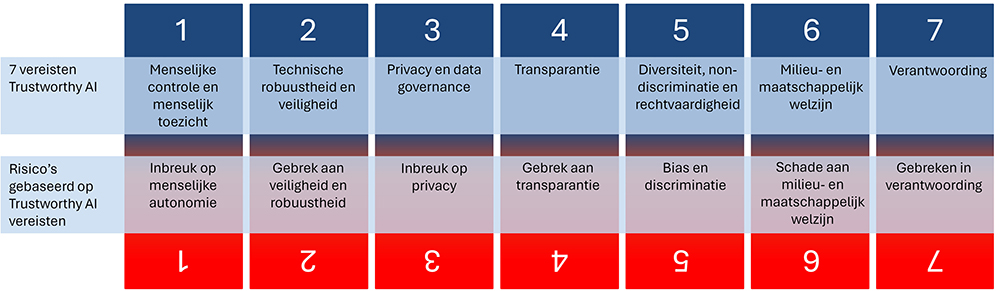

Het document Ethics guidelines for Trustworthy AI uit 2019 is in Europa een leidend document in het denken over AI-risicobeheersing. In het document wordt het concept trustworthy AI geïntroduceerd. Dit betekent dat AI wettig, ethisch en robuust moet zijn. Omdat er soms spanning zit tussen de realisatie van deze drie doelstellingen, zijn er vier ethische beginselen bepaald: respect voor menselijke autonomie, preventie van schade, rechtvaardigheid, verantwoording. De ethische beginselen worden verder geconcretiseerd in zeven belangrijke vereisten: 1) menselijke controle en menselijk toezicht, 2) technische robuustheid en veiligheid, 3) privacy en data-governance, 4) transparantie, 5) diversiteit, non-discriminatie en rechtvaardigheid, 6) milieu- en maatschappelijk welzijn, 7) verantwoordingsplicht. In figuur 1 zijn de zeven vereisten van trustworthy AI gekoppeld aan verschillende type risico’s van AI.

Waarom deze koppeling? Het voordeel van deze risicoclassificering is een consistent gebruik van de Europese trustworthy AI-terminologie. De internal auditor kan met behulp van deze Europese trustworthy AI-benadering in gesprek gaan binnen de organisatie over AI-risico’s. Van al deze risico’s zijn ruimschoots praktijkvoorbeelden te vinden. Het bestuderen hiervan is een goede manier om meer gevoel te krijgen bij de potentiële oorzaken en gevolgen van deze risico’s.

Welke insteek kiest de Europese Unie?

Met de AI-verordening wordt AI-regelgeving binnen Europa geharmoniseerd. Het voorstel bevat richtlijnen voor de risicobeoordeling en het beheer van AI-systemen. De Europese AI-verordening categoriseert AI-systemen in vier risiconiveaus: verboden, hoog, beperkt en laag risico. Hoogrisico-AI-systemen vormen het belangrijkste niveau. Dit zijn AI-toepassingen die biometrische gegevens gebruiken of bedoeld zijn voor kritische infrastructuur, onderwijs, werkgelegenheid, juridische processen en immigratie. Hoogrisico-AI-systemen moeten voldoen aan richtlijnen op het gebied van risicobeheer, data-governance, vastlegging van technische documentatie, logging, human oversight en cybersecurity. Voor hoogrisico-AI-systemen is verder een impact assessment verplicht gesteld naar de mogelijke effecten op grondrechten van personen of groepen. De Nederlandsche Bank en de Autoriteit Financiële Markten (AFM) geven in een recente publicatie De impact van AI op de financiële sector en het toezicht aan dat voor de meeste richtlijnen uit de Europese AI-verordening een implementatieperiode van twee jaar volgt.

Een belangrijk aspect dat de Europese AI-benadering kenmerkt is de nadruk op de ontwikkeling van mensgerichte AI. Een belangrijk onderdeel van deze visie zijn de human-oversightvereisten. Het doel van human oversight is om de menselijke waarden te handhaven bij geautomatiseerde besluitvorming en zo vertrouwen in deze technologie op te bouwen en te verstevigen in de maatschappij. Human oversight vervult volgens de AI-verordening een belangrijke rol in het signaleren van en ingrijpen bij ongewenste situaties met AI-systemen. Door sommige academici en techbedrijven wordt ter discussie gesteld of human oversight dit beoogde effect gaat realiseren. Een belangrijke zorg is dat de verplichting van human oversight kan resulteren in ongewenste bijeffecten zoals: schijnzekerheid, verspilling, toezichthouderbias, fouten en discriminatie. Verschillende academici schrijven dat kennis, accountability en invloed op het AI-systeem belangrijke randvoorwaarden zijn voor de effectiviteit van human oversight. Bij uitstek een interessant object van onderzoek voor de internal auditor!

Normenkaders voor AI

Naast regelgeving zijn er sinds 2020 ook waardevolle vaktechnische bronnen verschenen. Een overzicht van interessante AI-normenkaders:

- Auditdienst Rijk, Onderzoekskader Algoritmes, 2023.

- Algemene Rekenkamer, Toetsingskader algoritmes, 2021.

- NOREA, Guiding Principles Trustworthy AI Investigations, 2021.

- IIA, The IIA’s Artificial Intelligence Auditing Framework, 2024,

- NIST, AI Risk Management Framework, 2023.

- ICO, Guidance on the AI auditing framework Toolkit, 2022.

- Singapore PDPC, Model AI Governance Framework, 2020.

- GAO, An Accountability Framework for Federal Agencies and Other Entities, 2021.

- Borstel, Algorithm Assurance cube, 2020.

Sommige publicaties bevatten zeer gedetailleerde suggesties voor potentiële risico’s en beheersmaatregelen. Het aanbod vaktechnische bronnen kan overigens een overweldigend effect hebben. Verder roepen deze normenkaders vragen op als: welk normenkader past het best bij mijn organisatie? Wat is de overlap met bestaande normenkaders binnen mijn organisatie? Wat is de overlap met andere wetgeving? Zijn deze AI-normenkaders nog actueel gegeven de recente ontwikkeling in wet- & regelgeving? Wanneer voldoe ik eigenlijk aan de wettelijke vereisten? Houden deze normenkaders al rekening met generatieve AI-systemen?

AI en de IA

Welke toegevoegde waarde kan de internal auditor op het gebied van AI leveren? Het vertrekpunt is natuurlijk afhankelijk van de organisatie en context waarin de internal auditor werkt. Wordt er al gebruikgemaakt van AI-systemen of is de organisatie nog in een oriënterende fase? In beide gevallen kan de internal auditor een bijdrage leveren.

In de oriënterende fase kan de internal auditor een gesprekpartner zijn voor het management en andere functies die betrokken zijn bij de ontwikkeling van AI-competenties. De trustworthy AI-risicocategorieën kunnen worden gebruikt als discussieplaat. Hierdoor raakt de organisatie direct bekent met de Europese benadering van trustworthy AI die ten grondslag ligt aan de AI-verordening. Een mooie introductie!

Wie is verantwoordelijk voor de besluitvorming over AI-systemen? Wie bepaalt welke procedures er uitgevoerd moeten worden?

Bij organisaties die al AI-systemen gebruiken of ontwikkelen kan de internal auditor een stap verder gaan. Een logisch vertrekpunt is de vraag of er een register of overzicht beschikbaar is van de aanwezige AI-systemen. Een eerste stap is om gericht onderzoek te doen naar de governance. Wie is verantwoordelijk voor de besluitvorming over AI-systemen? Wie bepaalt welke procedures er uitgevoerd moeten worden? Wie is verantwoordelijk voor toezicht op AI-systemen? Dit maakt inzichtelijk welke taken zijn belegd en welke stakeholders bij het proces betrokken zijn.

Vervolgens is het interessant om door te vragen: wat er is vastgelegd over deze AI-systemen? Is er documentatie over het doel van het AI-systeem? Is er een risico- of impactanalyse uitgevoerd? Door AI-systemen en de risico’s in kaart te brengen kan worden gestart met een analyse naar de potentiële vereisten onder de Europese AI-verordening.

De logische vervolgstap is om te onderzoeken wat er is vastgelegd over de werking van de AI-systemen. Welke datasets worden er gebruikt? Hoe is de logica van de modellen getest? Zijn er noodstopprocedures? Hoe wordt er omgegaan met ethische dillema’s? De eerdergenoemde normenkaders kunnen helpen bij het inventariseren van deze vragen. Op basis van deze informatie kan de internal auditor de volwassenheid van AI-procedures binnen de organisatie inschatten. Hoe dan ook, AI is een onderwerp waar de internal auditor niet meer omheen kan!

Over

Mark van der Meulen MSc RC is sinds 2024 internal auditor bij Achmea. Daarvoor werkte hij ruim vijftien jaar in de financiële sector in diverse functies. Hij rondde in mei 2024 de opleiding Internal Auditing & Advisory af aan de Erasmus Universiteit in Rotterdam af met een onderzoek naar het beheersen van artificial-intelligencerisico’s.

Reacties (0)

Lees meer over dit onderwerp:

Oog voor de zachte kant van harde zorgregistraties

Horizontaal Toezicht Zorg richt zich op de rechtmatigheid van de zorguitgaven. Nu is er een praktisch kader, het volwassenheidsmodel, om soft controls te kunnen toetsen en verbeteren.

Lees meerStereotyperingsbias bij auditors tijdens videoconferentie

Kunnen door digitale achtergronden bij video conferencing vooroordelen ontstaan door stereotypering waardoor de oordeelsvorming van de auditor kan worden beïnvloed?

Lees meer

Wilt u ook een reactie plaatsen?

Voor het plaatsen van een reactie vereisen wij dat u bent ingelogd. Heeft u nog geen account? Registreer u dan nu. Wilt u meer informatie over deze vereiste? Lees dan ons privacyreglement.